Das von VMware schon 2003 entwickelte vMotion erlaubt einen unterbrechungslosen Umzug von laufenden virtuellen Maschinen zwischen ESXi-Servern, etwa für die Hardware-Wartung oder zur manuellen bzw. automatischen (DRS) Lastverteilung. Die parallele Nutzung mehrerer Netzwerkkarten beschleunigt diesen Vorgang.

vMotion ist das eigentliche Killer-Feature, das aus einem Produkt für die Server-Konsolidierung eine Business-Continuity-Lösung machte. Mit vMotion muss nämlich ein Rechenzentrum keinen Ausfall von Anwendungen mehr hinnehmen, nur weil einige Infrastrukturkomponenten ersetzt werden müssen. VMware hat das vMotion-Feature über die Jahre immer weiter ausgebaut. Hier die technologische Timeline zu vMotion bis vSphere 6.0, noch ohne Encrypted vMotion, das in der Version 6.5 hinzukam:

Grundlegendes Netzwerk-Design für vMotion

Vor vSphere 5 war das Entwerfen eines vMotion-Netzwerks relativ einfach. Man wählte nach Möglichkeit die schnellste physische Netzwerkkarte aus und fügte diese einem vMotion-Kernel-Adapter (VMknic) hinzu. So unterstützte beispielsweise schon vSphere 4.x Netzwerke mit 1 GB und 10 GB.

Die Einrichtung in Kurzform:

- VMkernel-Adapter auf einen Standard-vSwitch erstellen

- vMotion-Checkbox aktivieren

- IP-Adresse von Quell- und Ziel-Host im gleichen Subnetz, ggf. auch gleiches VLAN

- Zuweisen einer physikalischen NIC

Multiple-NIC-vMotion

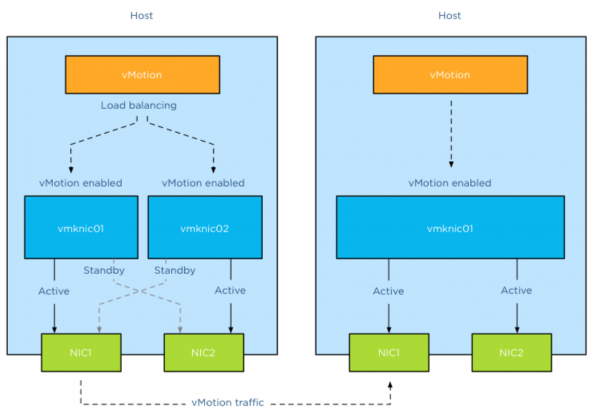

vSphere verteilt seit der Version 5.x vMotion-Vorgänge stets auf alle dafür verfügbaren Netzwerkkarten. Das gilt sowohl für eine einzelne als auch für mehrere gleichzeitige VM-Migrationen. So lässt sich durch Verwenden mehrerer NICs die Dauer eines vMotion-Vorgangs reduzieren.

Das bietet gleich mehrere Vorteile:

Manuelle vMotion-Prozesse: Weist man dem vMotion-Prozess indirekt mehr Bandbreite zu, verkürzt das allgemein die Migrationszeiten.

DRS-Lastausgleich: Aufgrund der kürzeren Zeit pro Migration und der höheren Anzahl der gleichzeitigen vMotion-Prozesse reduziert DRS bei Multiple-NIC-vMotion die Anzahl der Lastausgleichsvorgänge zwischen zwei Lastausgleichsläufen.

Dies kommt wiederum dem Load-Balancing des Clusters insgesamt zugute. Ein besserer Lastausgleich bewirkt eine höhere Verfügbarkeit von Ressourcen für die virtuellen Maschinen, was zu einer besseren Leistung für die Anwendungen führt.

Wartungsmodus: Kürzere Migrationszeiten bedeuten auch, dass ein einzelner Host weniger Zeit benötigt, um in den Wartungsmodus zu wechseln. Mit einem höheren Konsolidierungsgrad nimmt insgesamt die Zeit zu, die für die Migration aller virtuellen Maschinen vom Host erforderlich ist.

Multi-NIC-Setup

Der VMotion-Prozess nutzt für den Lastausgleich immer den VMKernel-Port (VMknic), anstatt Pakete direkt an eine physische Netzwerkkarte zu senden. Um also mehrere NICs für vMotion verwenden zu können, benötigt man mehrere VMKernel-Adapter.